参考链接:https://baijiahao.baidu.com/s?id=1622064575970777188&wfr=spider&for=pc

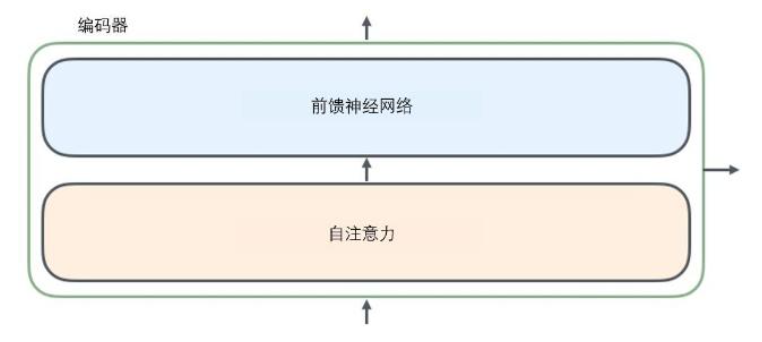

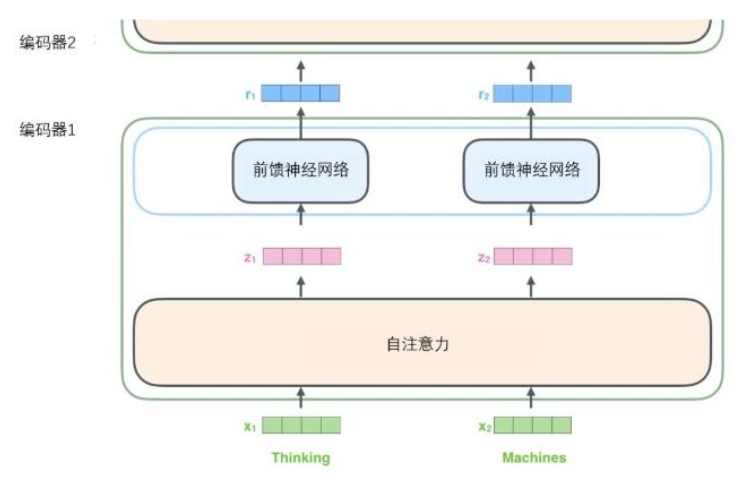

BERT的名字由来:Bidirectional Encoder Representations from Transformers

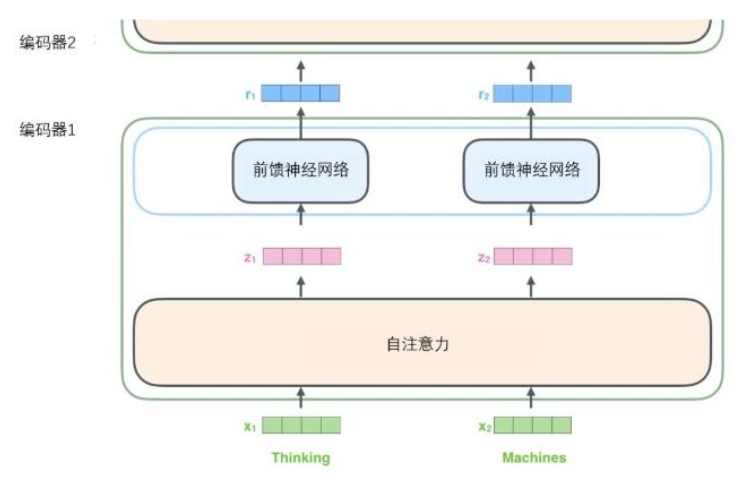

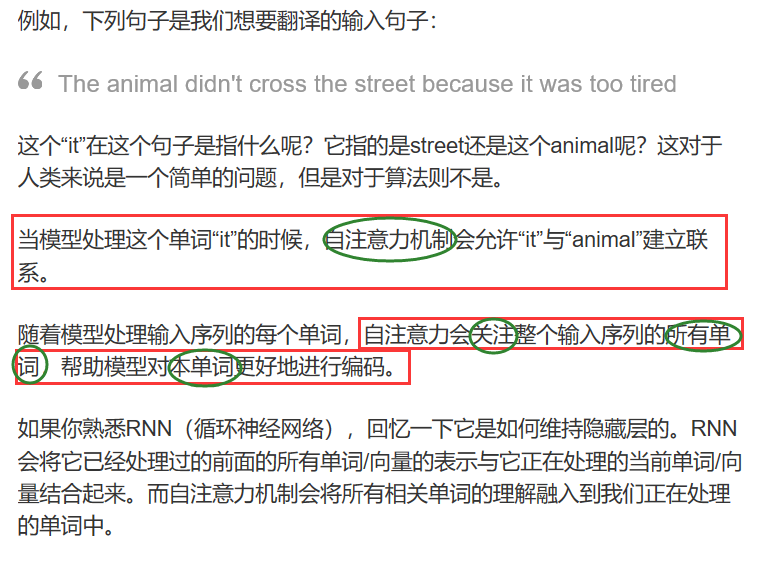

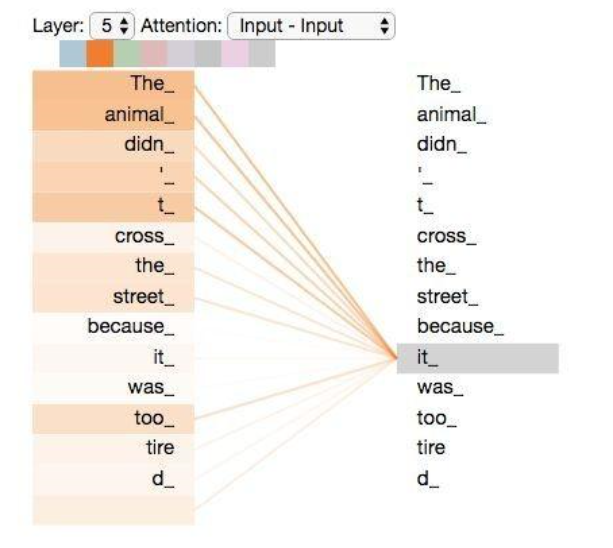

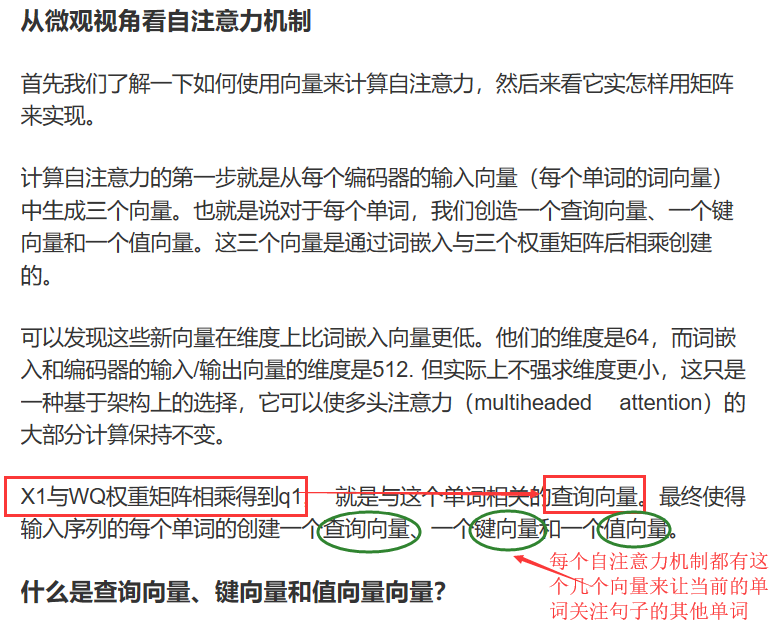

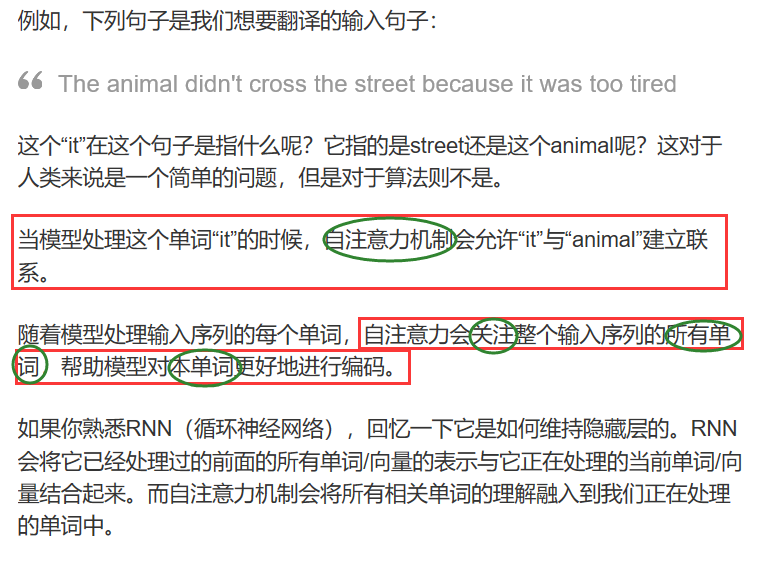

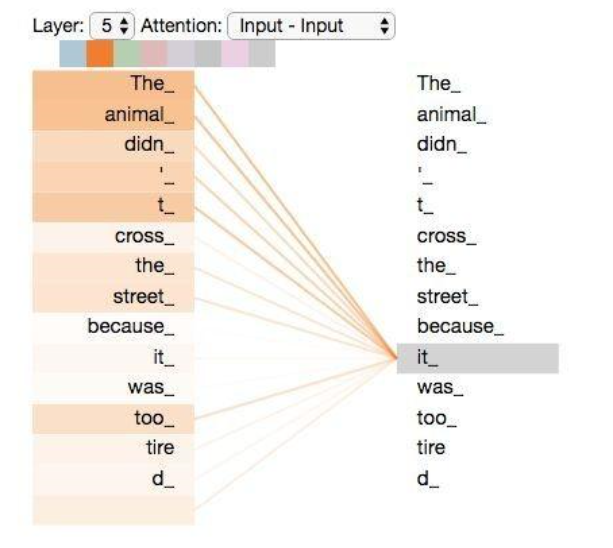

RNN会将它之前已经处理过的前面的所有单词/向量的表示与它正在处理的当前单词/向量结合起来。

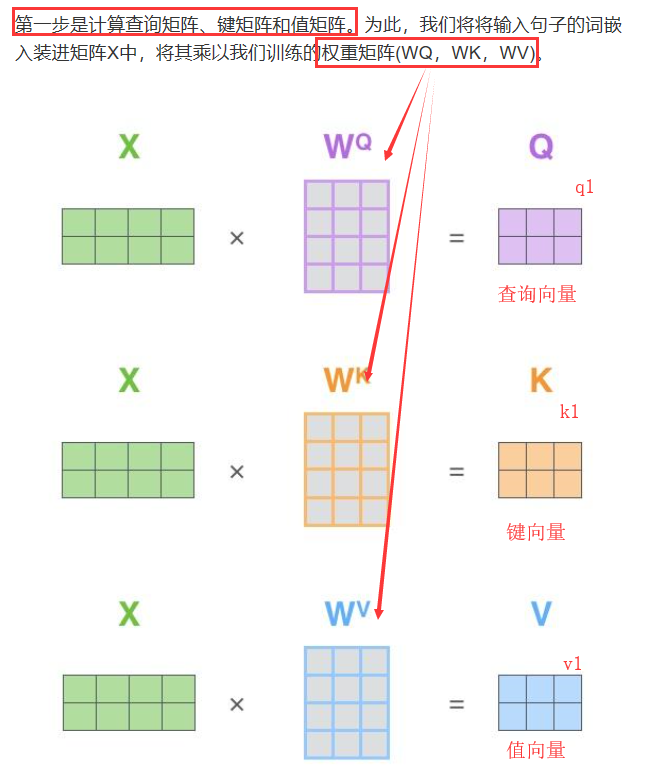

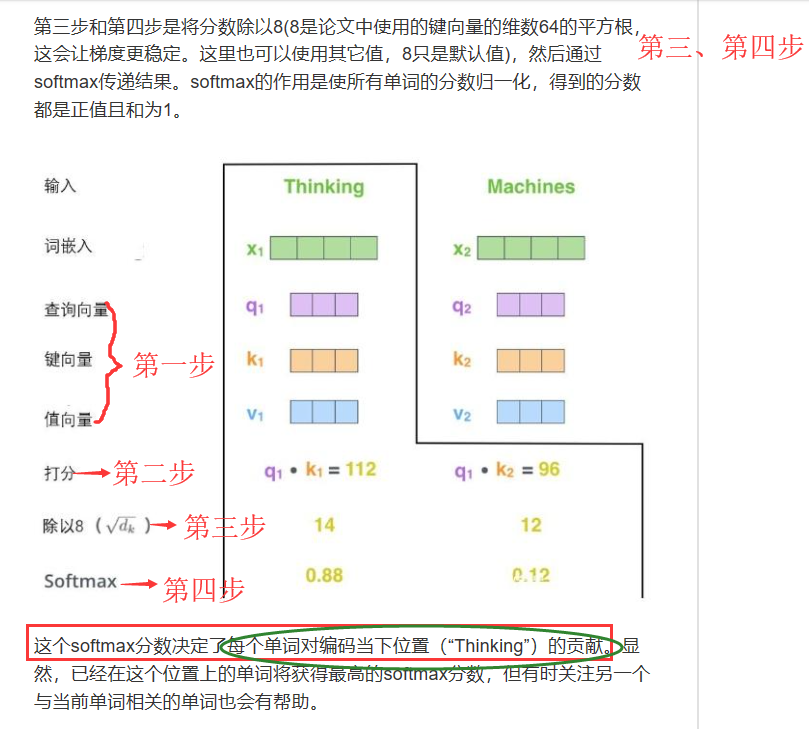

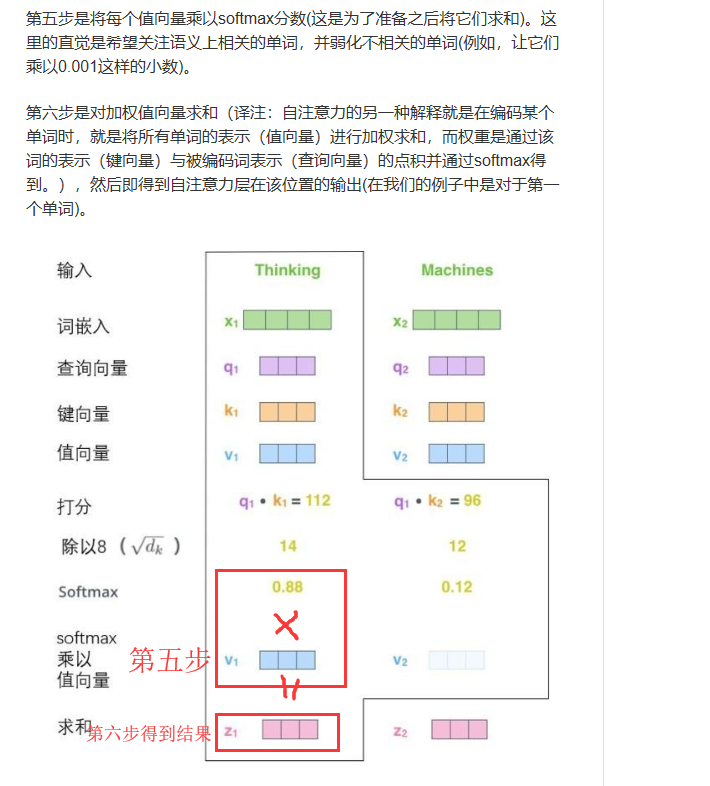

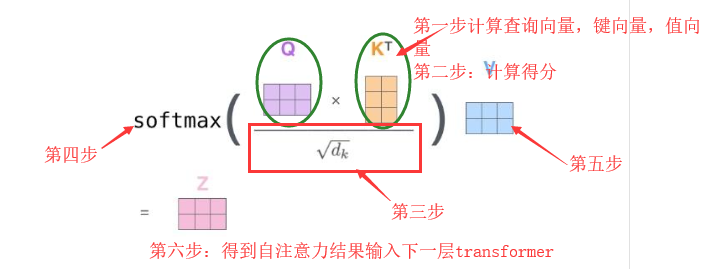

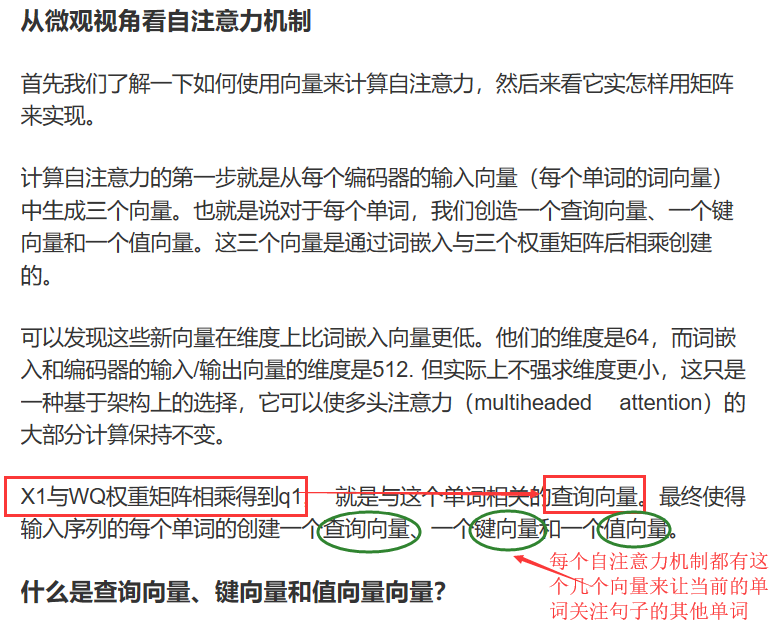

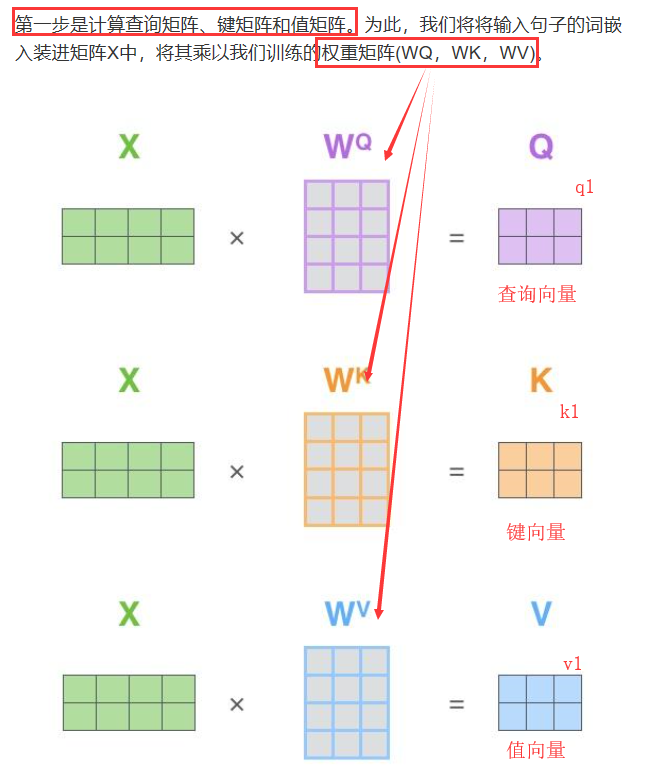

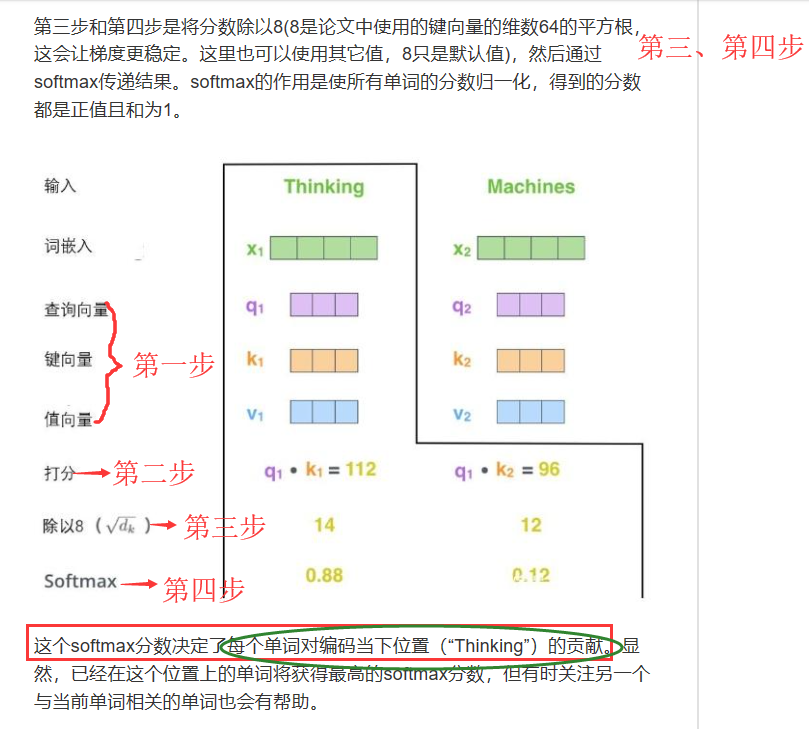

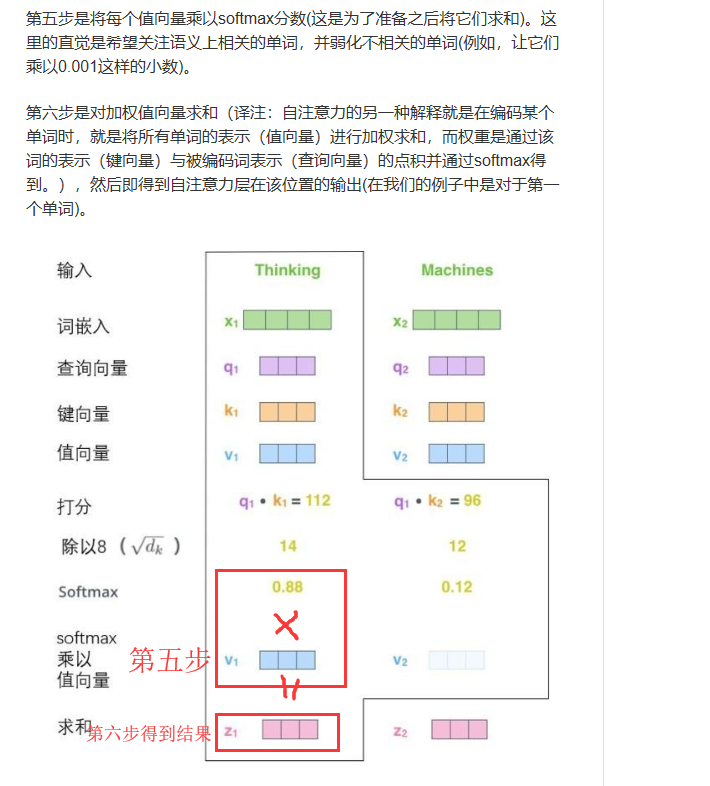

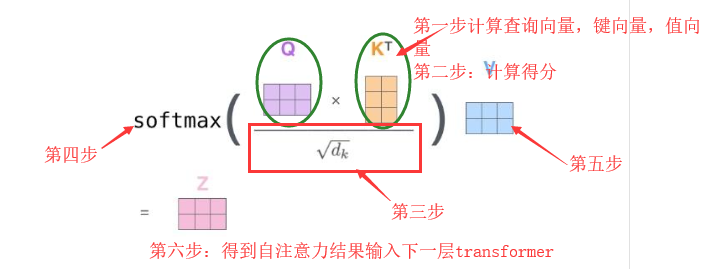

而注意力机制会将所有相关单词的理解融合到我们正在处理的单词中。

参考链接:https://baijiahao.baidu.com/s?id=1622064575970777188&wfr=spider&for=pc

BERT的名字由来:Bidirectional Encoder Representations from Transformers

RNN会将它之前已经处理过的前面的所有单词/向量的表示与它正在处理的当前单词/向量结合起来。

而注意力机制会将所有相关单词的理解融合到我们正在处理的单词中。

◎欢迎参与讨论,请在这里发表您的看法、交流您的观点。